275 rack oggi, 1 solo domani: il piano di AMD per l'intelligenza artificiale

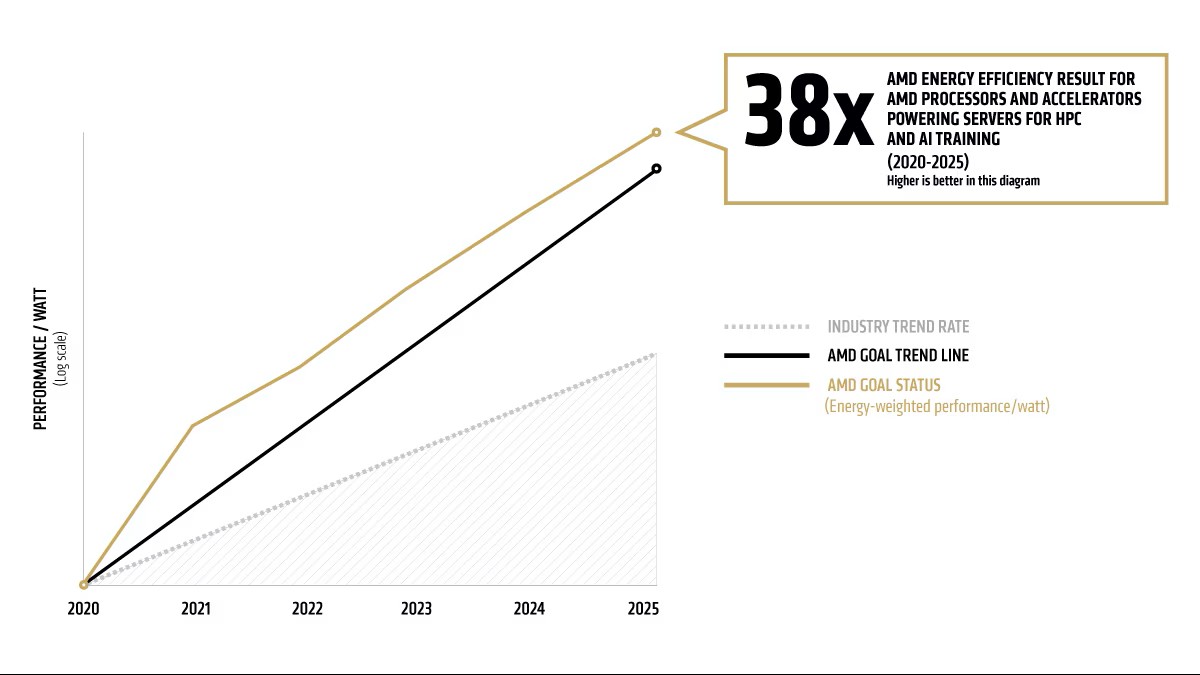

AMD ha superato l'obiettivo 30x25, migliorando di 38 volte l'efficienza energetica dei nodi AI e HPC rispetto al 2020. L'azienda alza la posta: aumentare di 20 volte l'efficienza energetica a livello di rack entro il 2030, puntando a una drastica riduzione dei consumi nei datacenter AI.

di Manolo De Agostini pubblicata il 16 Giugno 2025, alle 08:01 nel canale Server e WorkstationInstinctEPYCAMD

Nel corso dell'evento Advancing AI, AMD ha annunciato il superamento dell'ambizioso obiettivo 30x25. Come intuibile dal nome, con 30x25 la società guidata da Lisa Su si era prefissa di aumentare di 30 volte l'efficienza energetica dei nodi di calcolo per intelligenza artificiale e high-performance computing (HPC) entro il 2025 rispetto al 2020. La casa di Santa Clara ha invece raggiunto un miglioramento pari a 38 volte rispetto al livello base del 2020, grazie a un lavoro ingegneristico che ha interessato sia le architetture CPU che GPU.

Questo risultato si traduce in una riduzione del 97% dell'energia necessaria per ottenere le stesse prestazioni, se confrontate con sistemi di cinque anni fa. Il test è stato effettuato su una configurazione che include quattro GPU AMD Instinct MI355X e una CPU AMD EPYC di quinta generazione.

Clicca per ingrandire

Nonostante l'ottimo risultato, AMD ha deciso di non cullarsi sugli allori, rilanciando con un nuovo obiettivo: un incremento di 20 volte dell'efficienza energetica a livello di rack entro il 2030, prendendo come anno di riferimento il 2024. Questa nuova sfida riflette una consapevolezza crescente: mentre i miglioramenti a livello di nodo diventano meno incisivi su scala, le ottimizzazioni di sistema - che includono CPU, GPU, memoria, rete, storage e co-design hardware-software - diventano essenziali per una crescita sostenibile dell'AI.

Secondo AMD, l'impatto pratico di questo nuovo traguardo potrebbe essere significativo: un modello AI che oggi richiede oltre 275 rack per l'addestramento, nel 2030 potrà essere gestito in meno di un rack, con una riduzione del 95% dell'elettricità operativa e delle emissioni di CO₂ da circa 3.000 a 100 tonnellate. Le stime si basano su proiezioni interne validate dal noto esperto in efficienza energetica, il Dr. Jonathan Koomey, che ha elogiato AMD per l'utilizzo di metriche trasparenti e concrete.

Oltre all'hardware, AMD riconosce che l'evoluzione dei software e degli algoritmi giocherà un ruolo chiave: il miglioramento complessivo dell'efficienza energetica nella formazione dei modelli AI potrebbe arrivare a 100 volte entro il 2030, includendo approcci più intelligenti e l'uso di calcoli a precisione ridotta. Anche se AMD non rivendica direttamente questo risultato complessivo, l'azienda si propone come base tecnologica per abilitare tali traguardi, grazie a un ecosistema aperto e a strumenti come la piattaforma software ROCm.

L'attenzione, quindi, si sposta ora verso un'efficienza sistemica che guarda al futuro dei datacenter in un mondo in cui l'intelligenza artificiale richiede sempre più risorse, ma dove la sostenibilità energetica non può essere trascurata.

HUAWEI MatePad Pro (2025): display anti-riflesso e Wi-Fi 7 per il tablet 'Pro' perfetto

HUAWEI MatePad Pro (2025): display anti-riflesso e Wi-Fi 7 per il tablet 'Pro' perfetto Astro A50 Gen 5 dopo 6 mesi: sono davvero le migliori? Si poteva fare di più

Astro A50 Gen 5 dopo 6 mesi: sono davvero le migliori? Si poteva fare di più  AMD Advancing AI 2025: le nuove GPU per l'intelligenza artificiale

AMD Advancing AI 2025: le nuove GPU per l'intelligenza artificiale Una Xiaomi SU7 si scontra con 16 veicoli: mega incidente e conducente arrestata

Una Xiaomi SU7 si scontra con 16 veicoli: mega incidente e conducente arrestata Fino a 52 core e un TDP di 150 Watt: queste le sembianze del top di gamma Nova Lake di Intel?

Fino a 52 core e un TDP di 150 Watt: queste le sembianze del top di gamma Nova Lake di Intel? Gratis su Android arriva aPS3e, primo emulatore nativo per giochi PlayStation 3 su Play Store

Gratis su Android arriva aPS3e, primo emulatore nativo per giochi PlayStation 3 su Play Store Truffa delle GeForce RTX 4090 contraffatte, (quasi) indistinguibili da quelle originali

Truffa delle GeForce RTX 4090 contraffatte, (quasi) indistinguibili da quelle originali Scendono i prezzi dei mini droni DJI: Mini 3 a 329€ e Mini 4 Pro da 630€, perfetti senza patentino

Scendono i prezzi dei mini droni DJI: Mini 3 a 329€ e Mini 4 Pro da 630€, perfetti senza patentino Hacker si nasce: anche bambini di 11 anni sul forum Cracked.io. La polizia olandese identifica 126 utenti

Hacker si nasce: anche bambini di 11 anni sul forum Cracked.io. La polizia olandese identifica 126 utenti 3 PC portatili da 15,6'' sotto i 450€: prestazioni ottime e tanto spazio per lavorare e studiare

3 PC portatili da 15,6'' sotto i 450€: prestazioni ottime e tanto spazio per lavorare e studiare Più energia in meno spazio: le nuove batterie ad acqua pronte per lo stoccaggio

Più energia in meno spazio: le nuove batterie ad acqua pronte per lo stoccaggio Pulizia completa e potente a prezzo stracciato: un'interessante scopa elettrica scende sotto i 110€ su Amazon

Pulizia completa e potente a prezzo stracciato: un'interessante scopa elettrica scende sotto i 110€ su Amazon Criptovalute da energia rubata: succede in Russia, ecco cosa sappiamo finora

Criptovalute da energia rubata: succede in Russia, ecco cosa sappiamo finora HONOR 400: ha più senso del Pro? Recensione

HONOR 400: ha più senso del Pro? Recensione The Witcher 4: priorità alle console nello sviluppo del gioco, ma Xbox Series S potrebbe faticare

The Witcher 4: priorità alle console nello sviluppo del gioco, ma Xbox Series S potrebbe faticare DARPA rivoluziona l'energia: trasmessi 800 watt senza fili per 8,6 chilometri

DARPA rivoluziona l'energia: trasmessi 800 watt senza fili per 8,6 chilometri OPPO Find X8 Ultra: foto incredibili e tanta autonomia! La recensione

OPPO Find X8 Ultra: foto incredibili e tanta autonomia! La recensione

2 Commenti

Gli autori dei commenti, e non la redazione, sono responsabili dei contenuti da loro inseriti - infoTutta fuffa,non essendo verdi ma rossi,tutto questo è una cavolata,una fake news!

Comunque hanno fatto un bel lavoro.....

Tutta fuffa,non essendo verdi ma rossi,tutto questo è una cavolata,una fake news!

Comunque hanno fatto un bel lavoro.....

Sarcasmo 2:

in fondo hai ragione. Se non è verde è sicuramente fake news.

Devi effettuare il login per poter commentare

Se non sei ancora registrato, puoi farlo attraverso questo form.

Se sei già registrato e loggato nel sito, puoi inserire il tuo commento.

Si tenga presente quanto letto nel regolamento, nel rispetto del "quieto vivere".